Le passé éclaire le futur : l’histoire n’est pas si brève

Les pionniers

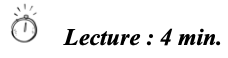

Au début du XIXème siècle, Joseph Fourier, dans son « Mémoire sur les températures du globe terrestre et des espaces planétaires » (1824) étudie les effets du rayonnement solaire et met en évidence que l’atmosphère limite les pertes d’énergie vers l’espace jetant les bases de ce qui sera appelé plus tard l’effet de serre.

30 ans plus tard, Eunice Newton Foote, militante féministe, établira que le CO est un gaz à effet de serre (GES) qui retient le rayonnement thermique émis par la terre, que l’origine de la chaleur soit naturelle (le rayonnement solaire) ou humaine (la combustion des fossiles).

John Tyndall, à la même époque, suggère que l’évolution de la présence de CO2 dans l’atmosphère peut avoir un impact sur le climat.

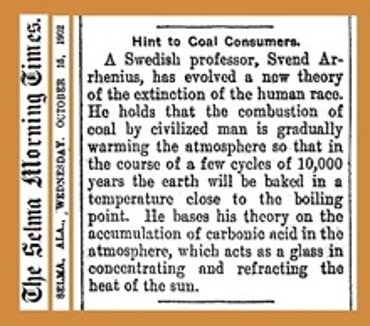

Et en 1896 Arrhenius, qui sera Prix Nobel de chimie en 1903, propose une première estimation de l’impact de l’accumulation de CO2 dans l’atmosphère sur les températures terrestres : un doublement de sa concentration conduirait à une augmentation de 4°C à 5°C de la température moyenne ! La presse se fera l’écho de ses prévisions comme l’illustre l’article du Selma Morning Times du 15 octobre 1902.

Le grand silence public

Dans la première moitié du XXème siècle, la plupart des scientifiques n’ont pas considéré qu’un accroissement des gaz à effet de serre conduirait à un réchauffement global. C’est ainsi que jusqu’aux années 1960 le sujet d’un potentiel changement climatique induit par l’activité humaine disparaît très largement des radars.

Certes, des mesures de température précises étaient largement disponibles depuis les années 1880 et des mesures relativement précises de la concentration de CO2 dans l’atmosphère existent depuis 1900.

Certes, dès 1938 et plus encore dans les années 1950, Guy Stewart Callendar, un ingénieur britannique, spécialiste de la machine à vapeur, s’était intéressé aux émissions de CO2 dues à la combustion des énergies fossiles, à l’augmentation de la concentration de CO2 dans l’atmosphère et au constat que, dans l’hémisphère Nord, les températures avaient augmenté. Mais ses travaux restèrent confidentiels, avant et après sa mort, en 1964.

Certes, Roger Revelle, un géologue américain développera les thèses de Callendar dans les années 1950 et 1960 et publiera en 1957 un article très cité sur les émissions de CO2 d’origine humaine et leurs interactions entre l’atmosphère et les océans. Certains considèrent Revelle comme le grand-père de la théorie du réchauffement climatique induit par le dioxyde de carbone.

Mais ces travaux ne firent aucune impression sur l’opinion et les décideurs.

C’est ainsi que le Rapport Meadows, The Limits to Growth, publié en 1972, a permis une première prise de conscience des impacts écologiques de la croissance économique. Il met en évidence les limites démographiques, économiques, techniques, et surtout écologiques à la croissance mais à la relecture de sa premières édition, les possibles impacts de l’a croissance économique sur le climat et en particulier le réchauffement induit par l’activité humaine en sont absents.

De Rio à Paris en passant par Kyoto

A partir des années 1960, les ordinateurs et les satellites ont offert de nouvelles méthodes d’analyse et de prédiction climatiques. Les climatologues disposent d’outils scientifiques de plus en plus sophistiqués leur apportant les moyens d’informer et de sensibiliser opinions publiques et décideurs. Un évènement retardera cependant la prise de conscience : la décennie 1970 sera marqué dans l’hémisphère nord par une phase de refroidissement qui fera même craindre l’arrivée d’une période de refroidissement global !

Ce n’est qu’en 1988 que l’ONU et l’Organisation Météorologique Mondiale (OMM) mettent en place le GIEC (Groupe d’experts intergouvernemental sur l’évolution du climat) qui recevra mission d’évaluer et de synthétiser l’état des connaissances scientifiques, techniques et socio-économiques disponibles, de façon neutre et objective, en rapport avec la question du réchauffement climatique.

Le troisième Sommet de la Terre, à Rio en 1992, verra la problématique du réchauffement climatique entrer dans l’agenda international. Au côté d’objectifs environnementaux (pollution de l’air et de l’eau, déchets, gestion des mers, désertification) et sociaux (logement, santé), le Sommet verra l’adoption de la Convention sur le Climat, qui affirme la nécessité de réduire les émissions de gaz à effet de serre.

Il faudra 5 ans pour que cette Convention prenne une forme contenant des objectifs concrets quantifiés, au travers du Protocole de Kyoto qui sera signé en décembre 1997 et vise à réduire entre 2008 et 2012 d’au moins 5% par rapport à 1990 les émissions de 6 gaz à effet de serre. Le Protocole de Kyoto n’entrera cependant en vigueur que début 2005 après sa ratification par 55 parties. Et nous avons vu qu’au niveau mondial la croissance des émissions de GES ne s’est pas ralentie.

Au milieu des années 2010 les connaissances des scientifiques sur le climat ont profondément changé : les incertitudes se sont atténuées et les certitudes renforcées. Le réchauffement global, 1°C depuis 1880 dont 0,7°C depuis 1980, est bien mesuré et « sans équivoque », son origine essentiellement humaine, essentiellement induite par les émissions de GES liées aux activités économiques, ne peut être mise en doute, augmentation de la concentration moyenne de CO2 dans l’atmosphère à l’appui. Le GIEC a développé de multiples scénarios d’évolutions possibles au cours du XXIème siècle, les plus optimistes limitant le réchauffement global à 1,5°C, les plus pessimistes l’amenant à 4°C.

L’Accord de Paris sur le climat se base largement sur ces travaux scientifiques. Adopté en 2015 et entré en vigueur en 2016, il a pour objectif de maintenir l’augmentation de la température moyenne de la planète en dessous de 2 °C , et de préférence de limiter l’augmentation à 1,5 °C. Il implique de réduire dès que possible les émissions de GES et d’atteindre le niveau Net Zéro dès le milieu du XXIème siècle.

Les marchands de doute

Les avancées scientifiques sur le climat n’ont pas arrêté le militantisme des marchands de doute. Claude Allègre n’est pas seul, loin de là. Et la palette d’arguments des marchands de doute est très large. Des deux côtés de l’Atlantique.

Bjorn Lomborg, statisticien danois, aura joui au début des années 2000 d’une renommée mondiale s’appuyant sur un volumineux ouvrage The skeptical environementalist publié par la prestigieuse Cambridge University Press. Time Magazine l’insèrera en 2004 dans la liste des 100 personnalités mondiales les plus influentes. La thèse de Lomborg est simple : globalement l’environnement ne cesse de s’améliorer et les conditions de vie humaines font de même. Le réchauffement climatique est un sujet parmi d’autres qu’il faut regarder dans une perspective très longue (un million d’années), de nombreuses causes peuvent être à l’origine du réchauffement global dont l’activité humaine, les scénarios du GIEC pour le futur sont incertains. Les conséquences (dérèglement climatique, impact sur l’agriculture et la santé, hausse du niveau des mers, etc.) sont donc surestimées voire inexistantes et, en tous cas, le coût pour réduire les émissions de CO2 est largement supérieur au coût d’adaptation au réchauffement. Enfin, Lomborg rejette toute option de modération de la croissance économique au motif de son inacceptabilité sociale. Le lecteur patient que j’ai été du skeptical environementalist en a tiré une conclusion : Lomborg fût un maître marchand du doute.

Lomborg fait fréquemment référence à William Nordhaus dans son argumentation. Sa contribution au doute est intéressante à analyser, d’autant plus qu’il a obtenu, en 2018, le prix Nobel d’économie pour ses travaux de modélisation économique du changement climatique. Sans nier le réchauffement lié à l’augmentation de la concentration de CO2, la thèse de Nordhaus, appuyée par son modèle, est qu’une réduction significative des émissions CO2 nécessite l’instauration de politiques économiques si rigoureuses, comme une forte taxe carbone, que le bilan économique actualisé en sera fortement affecté négativement. Il vaut mieux donc s’attaquer aux symptômes plutôt qu’aux causes. Lorsque le Congrès américain chargera en 1980 l’Académie nationale des sciences de réaliser une étude complète du CO2 et du climat, Nordhaus fût, avec Thomas Schelling, autre prix Nobel d’économie, la cheville ouvrière du volet économique. Et si les scientifiques spécialisés en climat conclurent que les dommages prévisibles pour l’environnement imposaient d’agir urgemment, les économistes eux suivirent les conclusion de Nordhaus : il était urgent d’attendre. 40 ans après, Nordhaus n’a pas changé d’opinion et ce d’autant plus que les faits semblent lui donner raison : l’humanité apparait incapable de prendre les mesures à même de s’attaquer efficacement aux causes. Mais son autorité scientifique y aura sans doute contribué.

Des journalistes d’investigation mettront en évidence en 2015 qu’ExxonMobil disposait dès la fin des années 1970, grâce à des collaborations scientifiques et dans des équipes internes, de modèles prévoyant l’impact des émissions de CO2 et l’ampleur du réchauffement attendu. D’autres major pétroliers mais aussi les industriels du charbon avaient la même connaissance. Un récent article de Science[1] met en évidence la très grande qualité des modèles utilisés par Exxon au début des années 1980 : la prévision de réchauffement est extrêmement proche des observations réelles. Cette connaissance n’empêchera jamais les responsables de ces industries de nier avec assiduité tout réchauffement et d’affirmer, avec la même assiduité, que les fossiles domineraient encore longtemps le système énergétique.

[1] Assessing ExxonMobil’s global warming projections, G. Supran, et al, Science, January 2023

© Michel Allé

Décembre 2023